Cože? Proč na můj web chodí roboti? Můžu jim to zakázat? Ano, můžete. Někdy se to dokonce kvůli crawl budgetu i hodí. Ale co vlastně znamená ten crawl budget? No, vezmeme to pěkně popořádku…

Jak funguje crawling a indexace

K pochopení významu crawl budgetu se nejrychleji dopracujeme přes vysvětlení, jak fungují samotné vyhledávače. Seznam i Google periodicky procházejí obsah World Wide Webu pomocí automatizovaných robotů neboli „crawlerů“. Robot navštíví váš web a projde určité množství jeho URL adres, jejichž obsah si zároveň stahuje. Pokud jej vyhodnotí jako užitečný, pošle ho k indexaci, čímž umožní zobrazení obsahu ve výsledcích vyhledávání. Jednoduché. Kde je problém? World Wide Web je neuvěřitelně robustní síť, která s každým dalším dnem existence bobtná do stále větších rozměrů.

„Roboti vyhledávačů při každé návštěvě vašich stránek zdaleka neprojdou všechny URL, na které narazí.“

Ve skutečnosti jich pravděpodobně projdou jen zlomek. A jestli to bude 1/5 nebo 9/10 udává právě crawl budget, který vám robot přidělí.

Co je to tedy crawl budget

Zjednodušeně si pod tímto pojmem můžete představit počet URL, které crawler Google, Seznamu nebo jakéhokoliv jiného vyhledávače projde za určitou dobu, třeba za jeden měsíc. Konečná velikost budgetu je dána dvěma hlavními faktory:

- Výkonností serveru — Roboti umí být při návštěvách opravdu bleskově rychlí. Zpravidla prohlížejí a stahují několik URL paralelně a vytváří tak množství požadavků na server. Crawleři Google a Seznam jsou však naštěstí dobře vychovaní a snaží se serverům neházet klacky pod nohy. Na základě zjištěných odezev serveru mu tak určí objem URL stáhnutých při jedné návštěvě takříkajíc „na míru“ (tzv. crawl limit).

- Přitažlivostí vašeho obsahu — Vysoký crawl limit je však jen půl úspěchu. Pokud je váš obsah nezajímavý pro uživatele, je nezajímavý i pro roboty. URL (včetně homepage) s vysokou návštěvností a množstvím zpětných odkazů, ať už externích, nebo v rámci webu, budou navštěvována často. Podobně bude váš web navštěvován častěji, pokud na něm pravidelně přibývá nový obsah. Naopak vysoce nepřitažlivý je obsah, který je duplicitní (a nachází se tak na vašem webu několikrát), starý nebo vrací chybové stavové kódy.

Jak zjistím svůj crawl budget

Všechno do sebe hezky zapadá, že? Určitě se už nemůžete dočkat, až uvidíte hodnotu svého crawl budgetu. V současnosti to spolehlivě zjistíte pouze pro Google. Jeho nástroj Google Search Console vám pomůže udělat si obrázek o tom, kolik toho tak roboti Google na vašem e-shopu denně či měsíčně projdou. Po přihlášení do nástroje vyberte v levé liště Procházení -> Statistiky procházení. Naskytne se vám pohled na několik grafů. Přidělený crawl budget zjistíte hned z prvního z nich:

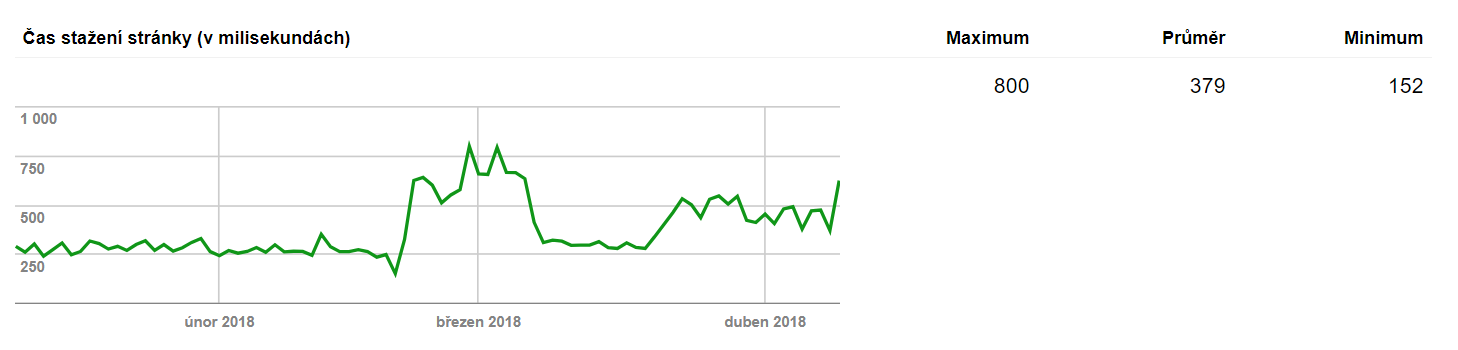

Náš příklad výše je český e-shop na míru s cca 140 000 URL adresami. V textu napravo od grafu vidíte objem URL, které Google robot průměrně projde za den doplněný o maximum a minimum sledovaného období. Propad během začátku března a přelomu následujícího měsíce má své opodstatnění (poznámka: tohle není e-shop z naší dílny a není na našem serveru). Pod modrým grafem totiž v GSC naleznete ještě jeden velmi zajímavý graf, tentokrát zelený.

Zelený graf znázorňuje průměrný čas nutný ke stažení jedné stránky webu. Pohled na obě křivky zároveň (modrou a zelenou) skvěle demonstruje vztah mezi crawl limitem, crawl budgetem a přitažlivostí obsahu. Na první pohled je patrná nepřímá úměra mezi časem potřebným ke stažení stránky a množstvím stránek, které v daném období Googlebot navštívil. Zběsilé kolísání počtu projitých stránek během února pak zřejmě zapříčinilo přidávání nového obsahu či zpětných odkazů.

Proč je nízký crawl budget problém

Nejprve si vyjasněme jednu věc: 99 % provozovatelů webových stránek si s crawl budgetem nemusí dělat starosti. Proč? Jejich projekty mají tak malý počet URL, že se o nedostatečný průchod roboty nemusejí bát. Pokud však vlastníte střední či větší e-shop se stovkami až desetitisíci produktů a neřešíte jej, hrozí vám, že vyhledávač:

- Včas nezjistí přítomnost nového obsahu— a nezařadí jej tak do indexu. A to proto, že se zrovna bude nacházet v těch 4/5 obsahu, který robot nestihne projít.

- Nebude brát ohled na změny vašeho obsahu — o revizi starých článků či jakýchkoliv jiných textů na webu by Google i Seznam rozhodně měli vědět. Pokud se tak nestane, můžete přijít o potenciální posun ve výsledcích vyhledávání.

V obou případech tak zbytečně přicházíte o návštěvníky, tržby a v konečném důsledku i zisk.

„Pokud je váš web špatně použitelný pro crawlery Google či Seznamu, bude taky špatně použitelný v rukou vašich potenciálních zákazníků.“

Až se budete příště prodírat nepřehledným a pomalým e-shopem, vzpomeňte si na nebohé roboty Google, kteří tento zážitek musejí absolvovat každý den.

Jak můžete svůj crawl budget zvýšit (nebo jím alespoň neplýtvat)

Možností je mnoho. Úzce souvisejí s faktory popsanými v sekci: „Co je to crawl budget“. Tipy k rozšíření crawl budgetu vašeho webu:

- Vytvářejte/nabízíte obsah, který je kvalitní — navštěvovaný a sdílený. Obsah, na který lidé sami od sebe odkazují. Čím lepší váš web v očích vyhledávače je, tím více času mu jeho roboti zpravidla věnují. Víme, že se tohle doporučení snadno říká a těžce praktikuje, ale nelze jej nezmínit.

- Vytvářejte XML mapy svých stránek a aktualizujte je — Nejlépe pokaždé, když přibude nový obsah. Dobře udělaná sitemapa účinně upozorní na nový obsah a celkově usnadní crawlerům průchod napříč strukturou.

- Investujte do moderního technického řešení stránkování a kanonizace — Některé starší řešení stránkování, filtrace produktů a řazení produktů na stránce mohou být v očích vyhledávačů vnímány jako duplicitní obsah a snižovat tak crawl budget webu.

- Zakažte robotům průchod nedůležitých URL — Ano, tohle fakticky nemá vliv na crawl budget jako takový. Vhodnými zákazy procházení v souboru robots.txt nebo pomocí meta tagů robots na jednotlivých stránkách webu můžete crawlerům výrazně zmenšit prostor, který mohou procházet. Množinu URL pak můžete ještě zmenšit pomocí zákazu procházení některých odkazů pomocí rel=“nofollow“ atributu. Se stejným crawl budgetem tak ve výsledku dosáhnete mnohem efektivnějšího procházení webu. Typicky se takto zabraňuje prohledávání stránek, které nikdy nebudeme chtít indexovat (nákupní proces, nesmyslné kombinace filtrů, uživatelské sekce, obchodní podmínky apod.).

- Důkladně propojte důležitý obsah vašeho webu — Pomocí hustého interního prolinkování můžete roboty přednostně posílat na ty stránky, které jsou pro vás nejdůležitější. Příklad: pokud máte e-shop, postarejte se o to, aby nejnovější produkty, kategorie a články byly po určitou dobu po vydání dostupné hned z homepage.

- Zajistěte si kvalitního poskytovatele webhostingu — Roboti se na rychlejších serverech odváží prozkoumat více URL než na těch pomalejších. Zvýšíte tak svůj crawl limit a tím pádem i potenciální crawl budget. Vždy však mějte na paměti, že sebevětší limit není zárukou vysokého budgetu. Váš obsah za to robotům musí stát.

Práce s crawl budgetem vám toho může hodně přinést. Ale také hodně vzít, pokud není udělána pořádně. Jakékoliv zásahy do způsobu procházení webu vždy nechte na SEO specialistovi, nebo jej minimálně konzultujte. Neváhejte psát na kuchovsky@itstudio.cz.